服务热线

15922223087服务热线

15922223087原标题:英伟达新核弹GPU:4nm制程800亿晶体管,全新Hopper架构太炸了

新卡取名H100,选用全新Hopper架构,直接集成了800亿个晶体管,比上一代A100足足多了260亿个。

内核数量则飙到了史无前例的16896个,到达上一代A100卡的2.5倍。

浮点核算和张量中心运算才能也随之翻了至少3倍,比方FP32就到达了到达60万亿次/秒。

特别注意的是,H100面向AI核算,针对Transformer搭载了优化引擎,让大模型练习速度直接×6。

作为一款功用爆破的全新GPU,不出意外,H100将与长辈V100、A100相同成为AI从业者心心念念的大宝物。

不过不得已提,它的功耗也爆破了,到达了史无前例的700W,重回核弹等级。

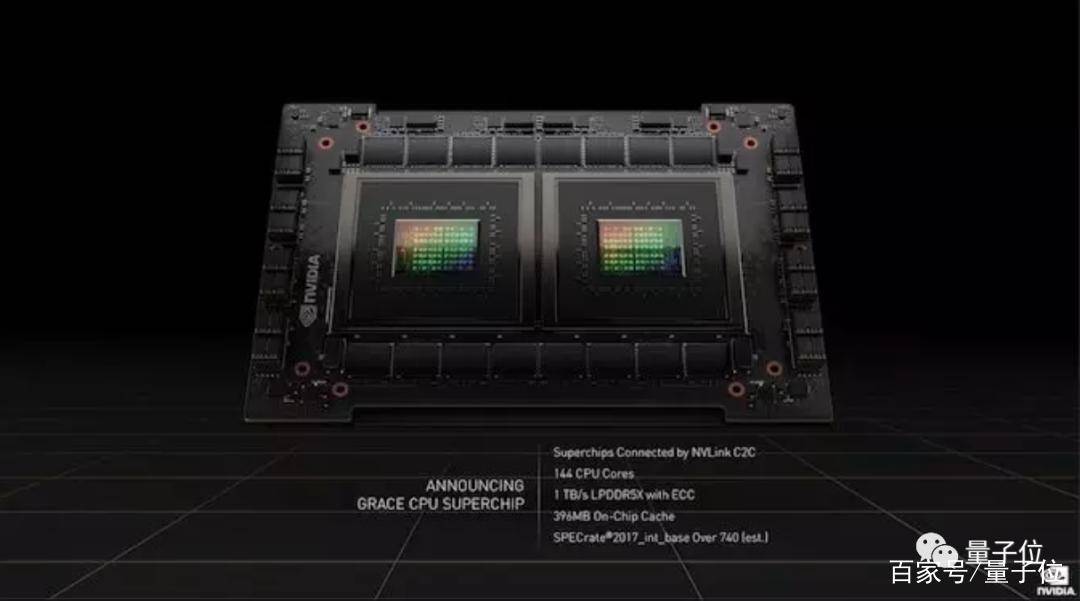

没想到,老黄从库克那里学来一手1+1=2,两块CPU“粘”在一起组成了CPU超级芯片——Grace CPU Superchip。

根据全新CPU、GPU根底硬件,这次发布会也带来了下一代企业级AI根底设施DXG H100、全球最快AI超算Eos。

当然,英伟达作为实在的元按例前驱,也少不了Omniverse上的新发展。

作为上一代GPU架构A100(安培架构)的继承者,搭载了全新Hopper架构的H100有多日新月异?

老黄可谓下血本,先是直接选用了台积电4nm工艺,晶体管一口气集成了800亿个。

要知道,上一代A100还仅仅7nm架构,这次发布会出来前,外界不少声响猜想老黄会用5nm制程,成果一发布就给我们来了个大惊喜。

最恐惧的是CUDA中心直接飙升到了16896个,直接到达了A100的近2.5倍。(要知道从V100到A100的时分,中心也不过添加那么一丝丝)

再看浮点运算和INT8/FP16/TF32/FP64的张量运算,功用根本悉数进步3倍不止,比较来看,前两代的架构晋级也显得小打小闹。

这也使得H100的热功耗(TDP)直接到达了史无前例的700w,英伟达“核弹工厂”当之无愧(手动狗头)。

线也是首款支撑PCle 5.0和HBM3的GPU,数据处理速度进一步飞升——内存带宽到达了3TB/s。

值得一提的是,Hopper架构的新GPU和英伟达CPU Grace姓名组在一起,就成了闻名女人核算机科学家Grace Hopper的姓名,这也被英伟达用于命名他们的超级芯片。

Grace Hopper发明晰世界上第一个编译器和COBOL言语,有“核算机软件工程”之称。

这次,老黄特意在发布会上着重提到了Hopper初次装备的Transformer引擎。

嗯,专为Transformer打造,让这类模型在练习时坚持精度不变、功用进步6倍,意味着练习时刻从几周缩短至几天。

现在,无论是练习1750亿参数的GPT-3(19小时),仍是3950亿参数的Transformer大模型(21小时),H100都能将练习时刻从一周缩短到1天之内,速度进步高达9倍。

推理功用也是大幅度的进步,像英伟达推出的5300亿Megatron模型,在H100上推理时的吞吐量比A100直接高出30倍,呼应推迟降低到1秒,能够说是完美hold住了。

在此之前,英伟达一系列GPU优化规划根本都是针对卷积架构进行的,挨近要把“I love 卷积”这几个字印在脑门上。

当然,H100的亮点不止如此,伴随着它以及英伟达一系列芯片,随后都会引进NVIDIANVLink第四代互连技能。

这次,老黄还着重提到了GPU的安全性,包含实例之间具有阻隔维护、新GPU具有秘要核算功用等。

这次H100上新的DPX指令能加快动态规划,在运算途径优化和基因组学在内的一系列动态规划算法时速度进步了7倍。

据老黄介绍,H100会在本年第三季度开端供货,网友戏弄“估量也廉价不了”。

一个便是功率高达700W的SXM,用于高功用服务器;另一个是适用于更干流的服务器PCIe,功耗也比上一代A100的300W多了50W。

根据H100推出的最新DGX H100核算体系,与上一代“烤箱”相同,相同也是装备8块GPU。

各GPU之间的衔接速度也变得更快,900GB/s的速度挨近上一代的1.5倍。

最要害的是,这次英伟达还在DGX H100根底上,搭建了一台Eos超级核算机,一举成为AI超算界的功用TOP 1——

光就18.4 Exaflops的AI核算功用,就比日本的“富岳”(Fugaku)超级核算机快了4倍。

即使是传统科学核算,算力也能到达275 Petaflops(富岳是442 Petaflops),跻身前5的超算是没什么问题。

它在上一年4月份的GTC大会就现已有所露脸,和其时相同,老黄表明:有望2023年能开端供货,横竖本年是不或许碰上了。

一个是Grace CPU超级芯片,由两个Grace CPU组成,经过NVIDIA NVLink-C2C技能互连,包含144个Arm中心,并有着高达1TB/s的内存带宽——带宽进步2倍的一起,能耗“只需”500w。

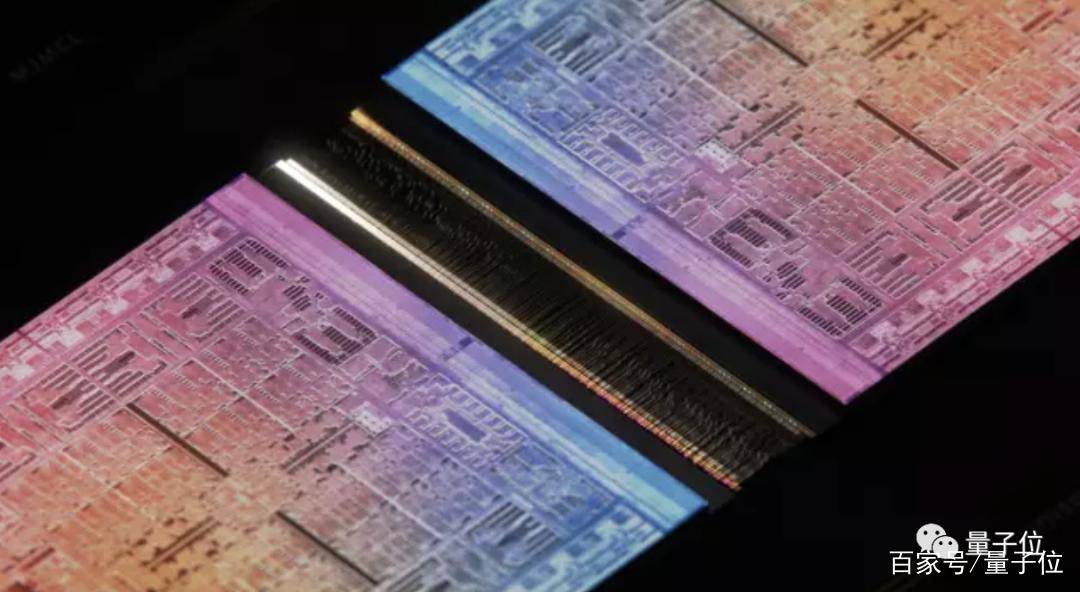

很难不让人联想到苹果刚发的M1 Ultra,看来片间互连技能的发展,让“组装”成了芯片职业一大趋势。

Grace超级芯片能够运转在所有的NVIDIA核算渠道,既可作为独立的纯CPU体系,也可作为 GPU加快服务器,使用NVLink-C2C技能搭载一块至八块根据Hopper架构的GPU。

它是一种超快速的芯片到芯片、裸片到裸片的互连技能,将支撑定制裸片与NVIDIA GPU、CPU、DPU、NIC 和SOC之间完成共同的互连。

而无论是无人驾驭、仍是包含虚拟工厂的数字孪生等场景,都与核算机烘托和仿真技能有着密不可分的联系。

英伟达以为,工业上相同能经过在虚拟环境中模仿的方法,来添加AI练习的数据量,换而言之便是“在元按例里搞大练习”。

例如,让AI智能驾驭在元按例里“练车”,使用仿真出来的数据搞出半实在环境,添加一些或许突发毛病的环境模仿:

又例如,搞出等比例、与实际环境中资料等参数彻底相同的“数字工厂”,在制作前先提早开工试运转,以及时排查或许呈现一些显着的反常问题的环境。

在这方面,英伟达推出了随时随地能在云端协作的Omniverse Cloud。

用它生成动画无需再绑定骨骼、k帧,用自然言语下指令即可,就像导演和真人艺人相同交流,快速缩短开发流程。

Venturebeat对此点评称,“这些事例给元按例赋予了实在的含义”。

© 2016-2018 乐鱼体育官方首页_app官网下载登录 版权所有

备案号:津ICP备14003658号-23

关注我们